「データが膨大で処理に時間がかかる」「複雑なデータの前処理に追われている」「データ分析できる人材が不足している」

このようなデータ活用の課題に直面していませんか?

本記事では、2024年6月19日開催のウェビナー「データサイエンティストが教えるデータ分析のヒント」の内容を元に、これらの課題をデータ分析プラットフォーム「Alteryx(アルテリックス)」がどのように解決し、データ活用を加速させるか、具体的な方法論と成功のヒントをご紹介します。

データ活用の現状

近年、インターネットユーザ数の爆発的な拡大が想定されています。インターネットユーザ数が、年平均成長率6%で増加していて、昨年の2023年には世界全体で53億人、つまり世界人口の 66%に達することとなりました。言い換えると、世界人口の約3分の2がインターネットにアクセスできるようになりました。インターネットに接続するデバイス数の増加にともない、データ流通量の爆発的な拡大され、データサイエンティストへのニーズも大きくなっている状況です。

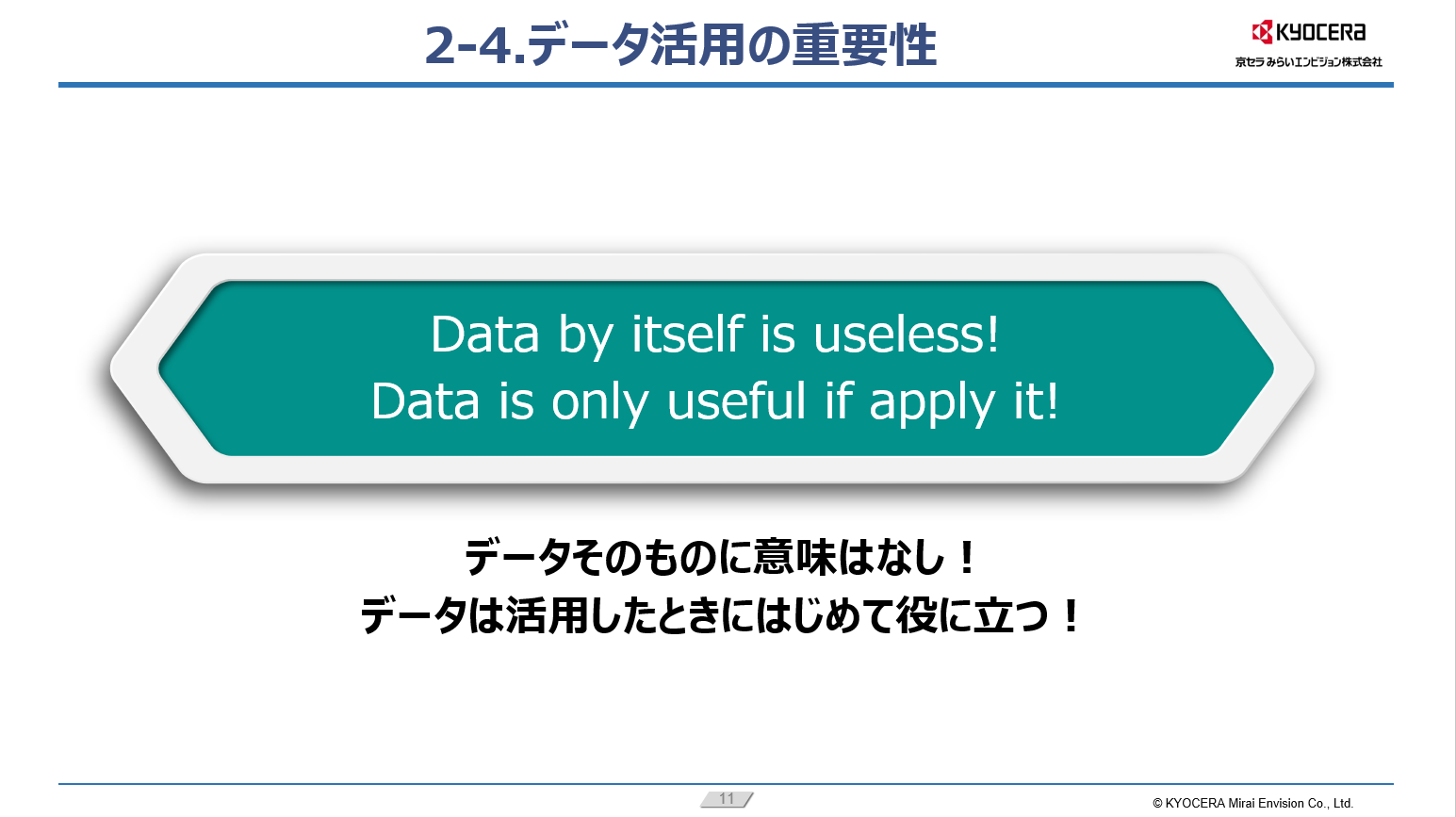

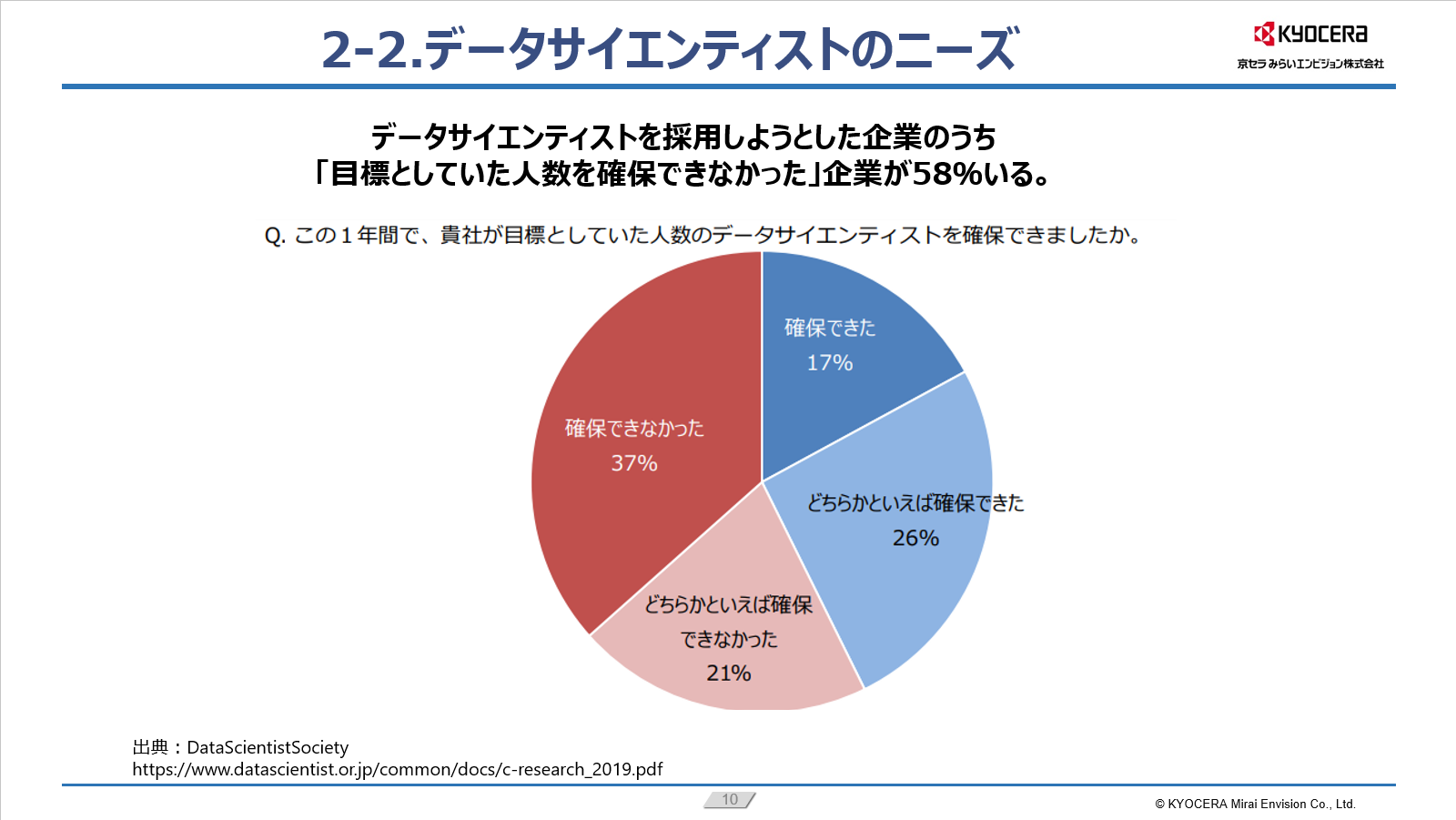

実際に上記資料の通り、企業へ「一年間目標としていたデータサイエンティストの数を確保できた」かどうかというアンケートに対して、60%近くの企業は確保できなかったと回答しています。このデータからもわかる通り、日本ではデータサイエンティストの人員不足という課題があります。またデータサイエンティストの中でも統計や人工知能などの知識を持って専門的な分析できる人材より、データを活用してビジネスの課題を解決できるようなタイプとデータ収集、加工及びシステム上の運用ができるタイプが合計76%を占めていることがわかりました。

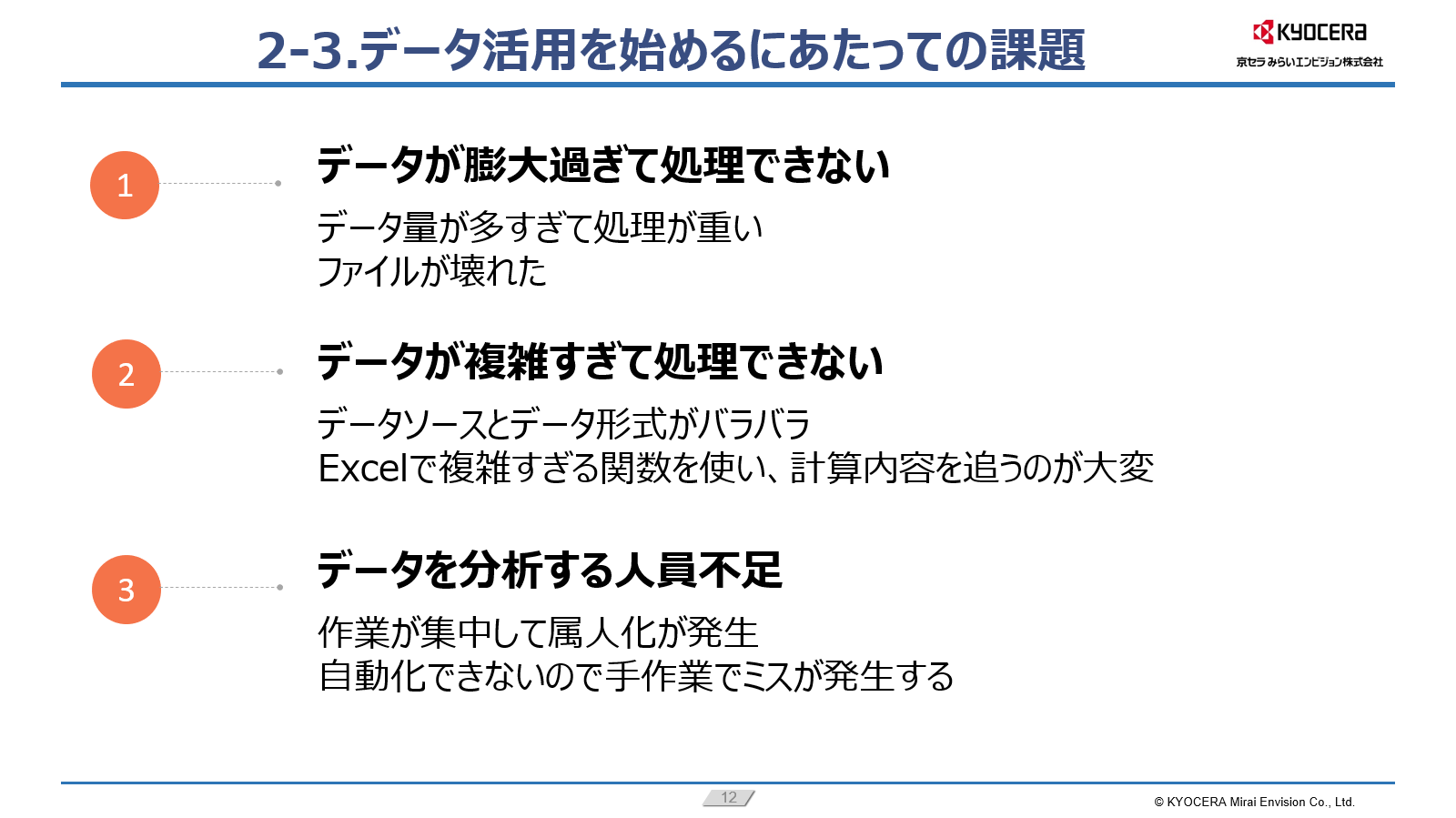

データ活用の主な課題

データ活用関連の背景を踏まえ、いざデータ活用をはじめようとした際に、出てくる課題として次の3つがあげられます。

1つ目はデータが膨大過ぎて、処理ができないという課題です。

分析に使うデータ量が増加し、蓄積していくと、処理が重くなったり、容量の限界を超えたファイルが、使用中に壊れる可能性が高くなり、データの処理を行えなくなることが出てきます。

2つ目はデータが複雑すぎて、処理ができないという課題です。

データを入手する手段や、データソースが増えていくと、データの中が複雑になり、処理する途中でゴールを見失ってしまうことがあります。データの管理や処理の過程を可視化することが課題となってきます。

3つ目は、データを分析する人員の不足です。

データサイエンティストが不足しているので、作業が特定の方に集中しやすくなってしまいます。手順書やマニュアルを作成していないと、担当者の部署異動が有った際の引き継ぎをスムーズに行うことが出来ません。例えば、Excelでデータ分析している際、なにかデータ分析の方法で修正が発生した際は、また1から関数を組み直さなければならないといったことが発生します。また、人手不足の中、毎月繰り返す処理等のルーティン化された分析の自動化が実現されていないと、毎月同じような作業に時間をとられ、さらに手作業によるミスが発生する恐れもでてきます。

これらの課題を解決するため、データに対しての理解を深め、データ分析のプロセスをより簡単に行う必要があると思いますので、スピーカーの経験をもとにデータ分析の考え方とヒントをご紹介させていただきます。

データ分析の考え方

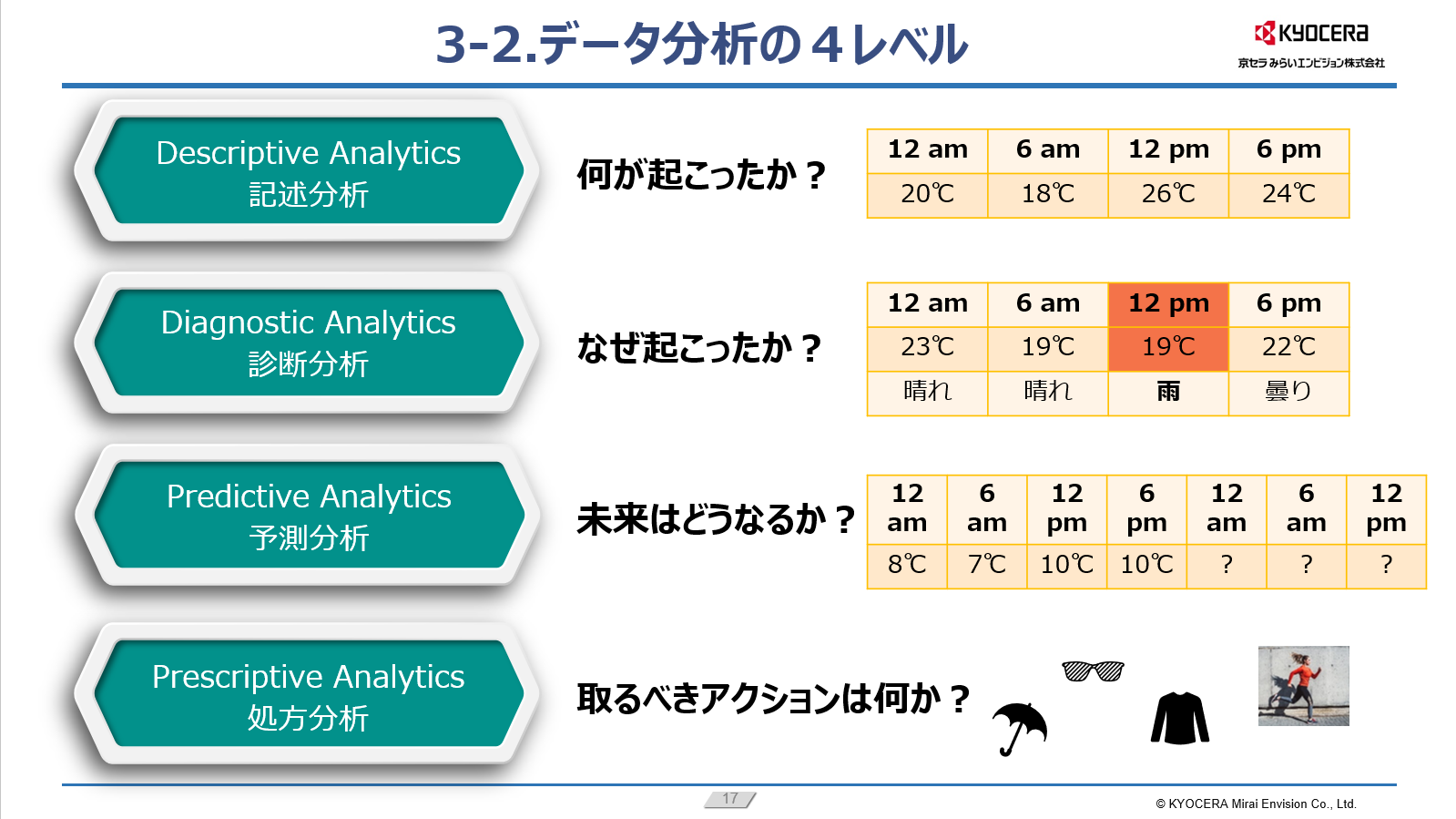

データ分析の手法は進化し続けていますが、データから得られる知見のレベルによって、大体4つのカテゴリに分けられます。

記述分析とは「何が起こったか?」を理解するための分析です。

例えば、日々特定時間帯の気温の記録データを通じて、日中気温のピーク時間がわかります。

診断分析は、ある現象がなぜ起こったのかを理解する際に行います。この分析では、各測定値の関係が考慮される必要があります。たとえば、スライドの例の場合、異常な気温測定値は、雨が降っていたのが原因であることがわかります。

予測分析では、今まで得られた実際のデータを利用し、これから起こり得る結果を予測します。つまり、特定の条件でその事象が起こる確率が高い、ということがわかります。

処方分析は、分析に基づいてとるべきアクションを論理的に提案することです。

データ分析のヒント

データ調査、データ準備、そしてデータ分析の自動化、つまり、ワークスマートに分けてお話させていただきます。

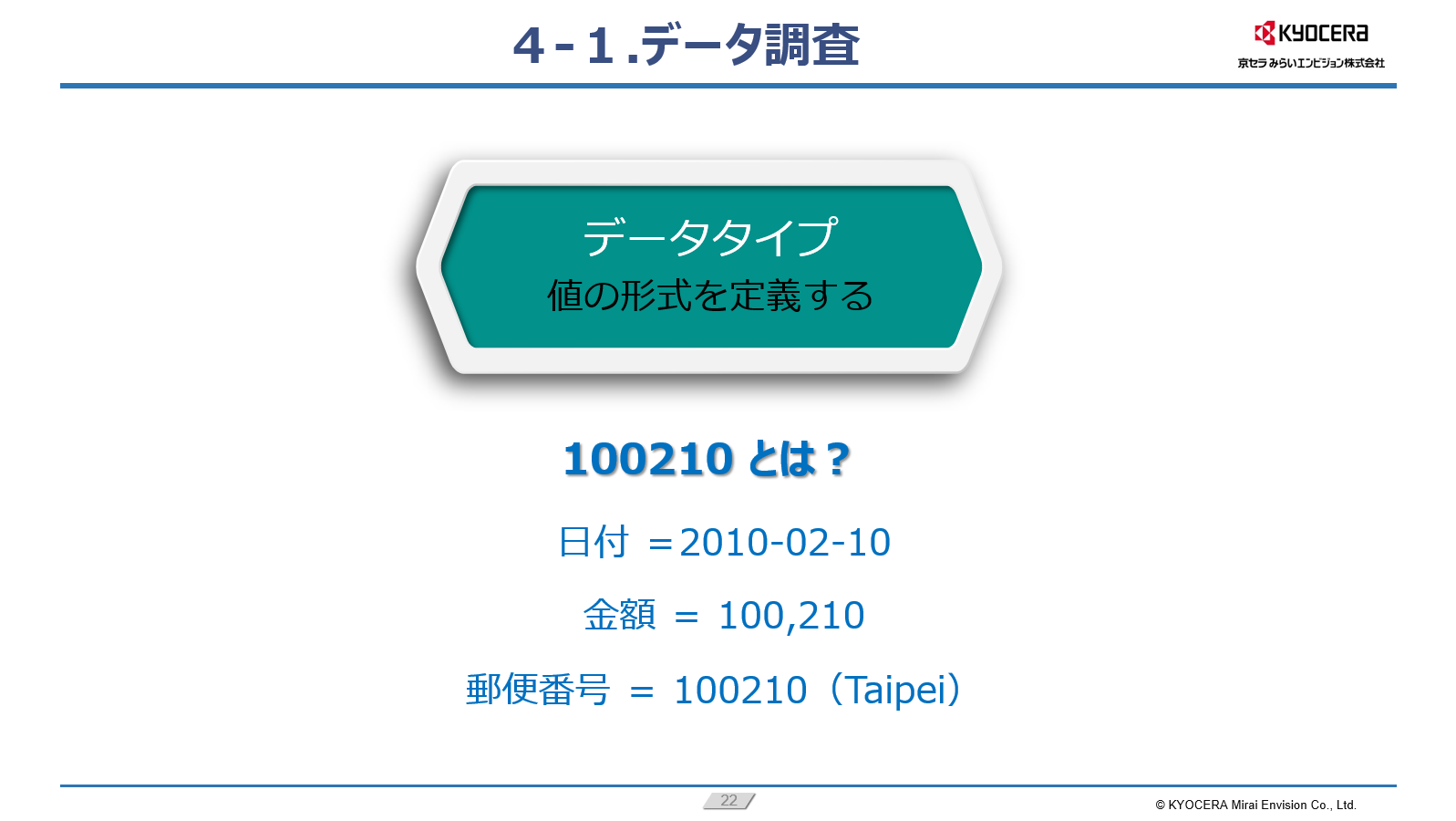

まず、データ調査についてです。データは数値形式とは限らないので、データの構成要素に対して、柔軟な見方が必要です。

データは定量データ (数値データ) と定性データ (通常はテキストデータ) に分類されます。もう1つのデータ分類の方法は、データの形式を参照して、データを構造化、半構造化、または非構造化の3種類に分けられます。構造化データは通常テーブルに値を配置する表形式のデータを言います。半構造化データは通常集めたデータに合わせてタグをつけるように保存されており、代表的な形式はJSON、XMLです。非構造化データはメディア、画像、音声、テキストなどを含みます。構造化データは、分析には一番使いやすいデータ形式ですので、半構造化データや非構造化データを構造化データに変換することは、データ分析には必須なプロセスです。

データソースもスプレッドシートやExcel、Word、Pages、メモ帳など多岐にわたります。それぞれのファイルによってデータが保存される手法やファイルを開けるプログラムが異なるため、事前にデータの共有方法や読み込み方を明確にしておく必要があります。

またデータ調査時にデータタイプの確認が必要です。例えば、100210という値だけを見た時、皆さんはなんの値だと思うでしょうか?

日付でしょうか、金額でしょうか、もしくは郵便番号でしょうか。データタイプによって、その値が持つ情報が変わってきますそのため、その値の実際の使い方に応じて、事前に値の形式、データタイプを定義する必要があります。

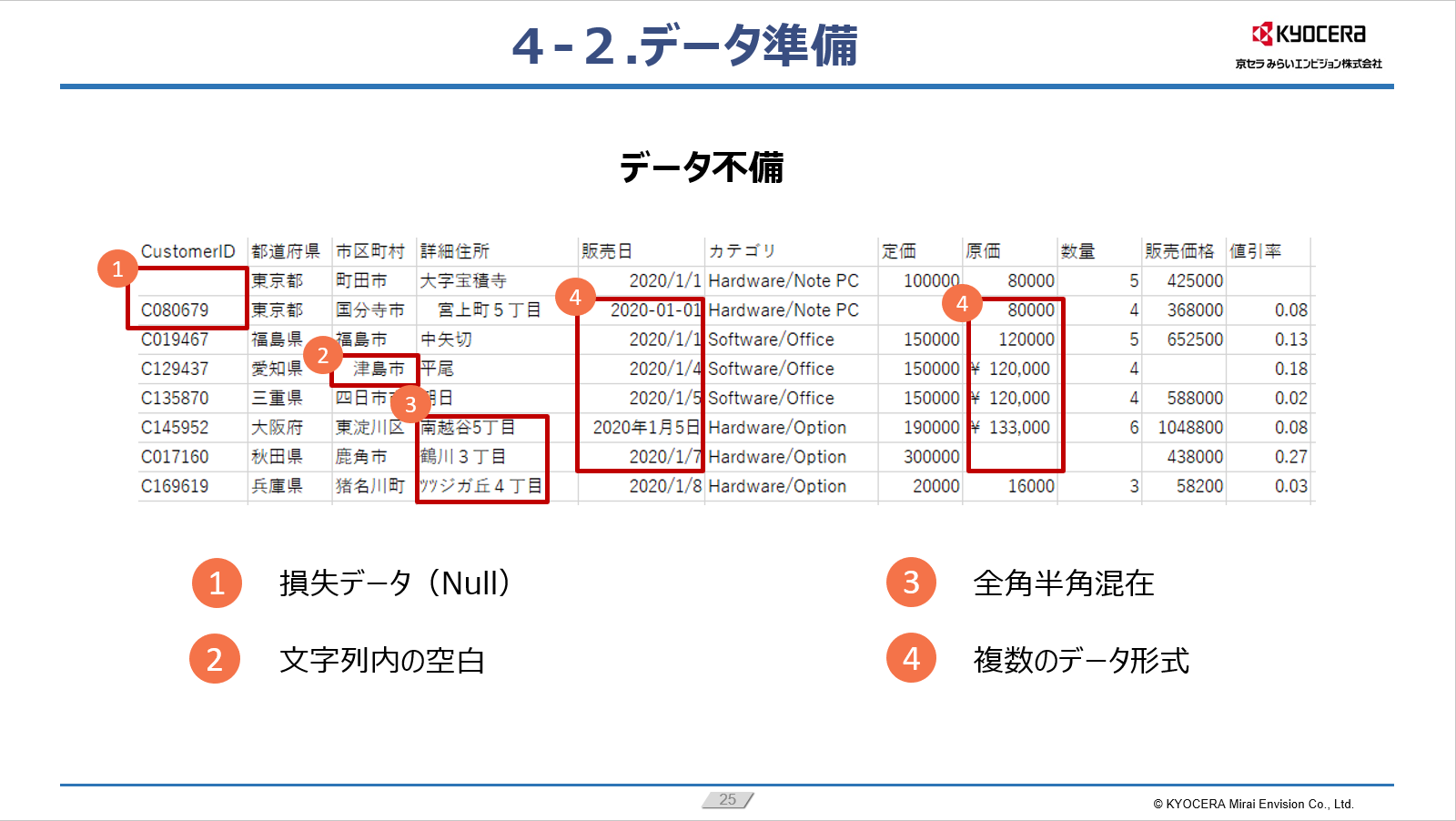

次にデータ準備についてです。実際のデータは、乱雑だったり不備があることが多くあります。入手したデータの値が欠落していたり、異常値が含まれていたり、必要な情報が含まれていなかったりすることはよくあることです。例えば、下の表は、データの不備があるため、このまま使うとデータ分析をスムーズに行うことができません。

①はデータが入っていない損失データがあります。このNullデータに対して対処をしないと、後々の集計や突合処理をする際に影響がでてきます。②は文字列内に空白があります。③のように全角半角が混在してしまうことも実際の業務の際に多々出てくるのではないでしょうか。また、異なるデータソースを使用すると、④のように日付や数字の形式が異なる場合があります。このまま分析を進めようとすると、データタイプが変わってしまう恐れがあります。

このようなデータ不備を直しデータの質を向上させるために、データラングリングと呼ばれる望ましい形式へ変換する作業が大切です。

最後にデータ分析の自動化、ワークスマートについてです。新しいデータセットに対して同じアクションを何度も実行するのは効率的ではないため、データ分析には何度も実行できる、自動化されたソリューションが求められます。こうすることで、同じクレンジング手法を新しいデータセットに適用して、手作業の時間を省けます。

自動化ソリューションのアルゴリズムは、現在のデータセットに適合するだけではなく、将来データが変化する可能性も考慮して対応する必要があります。このような人の手修正を必要とせずに、自動で新しいデータを処理できるように構築されるソリューションは、「動的なソリューション」としても流行っています。これらのソリューションを活用することでワークスマートを促進することが出来ます。

動的な自動化ソリューションとしてデータ分析ツールAlteryxの紹介

最後に、データ調査、データ準備、そしてデータ分析の自動化を網羅できるセルフ分析ツール、Alteryx(アルテリックス)についてご紹介させていただきます。

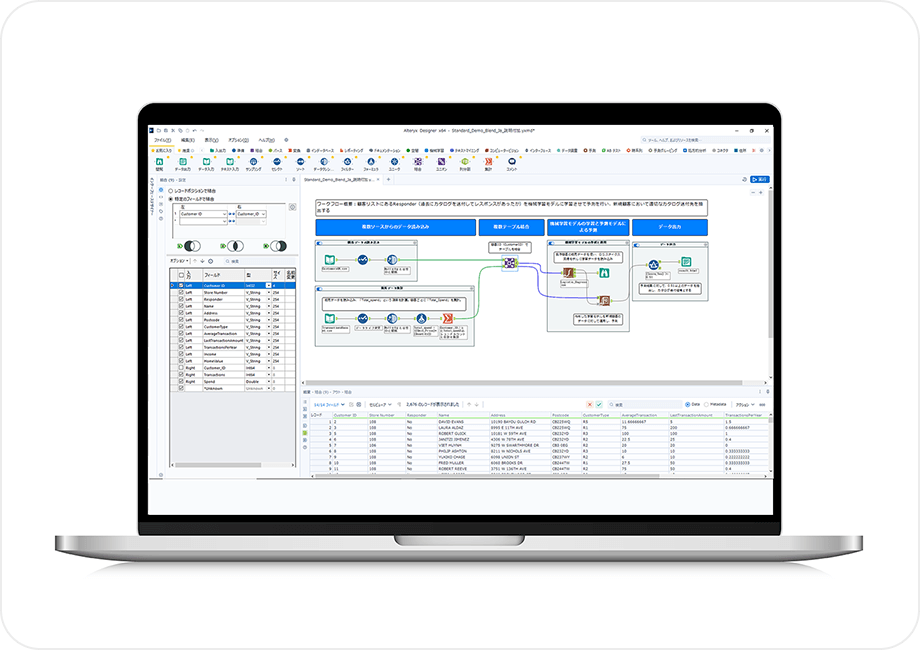

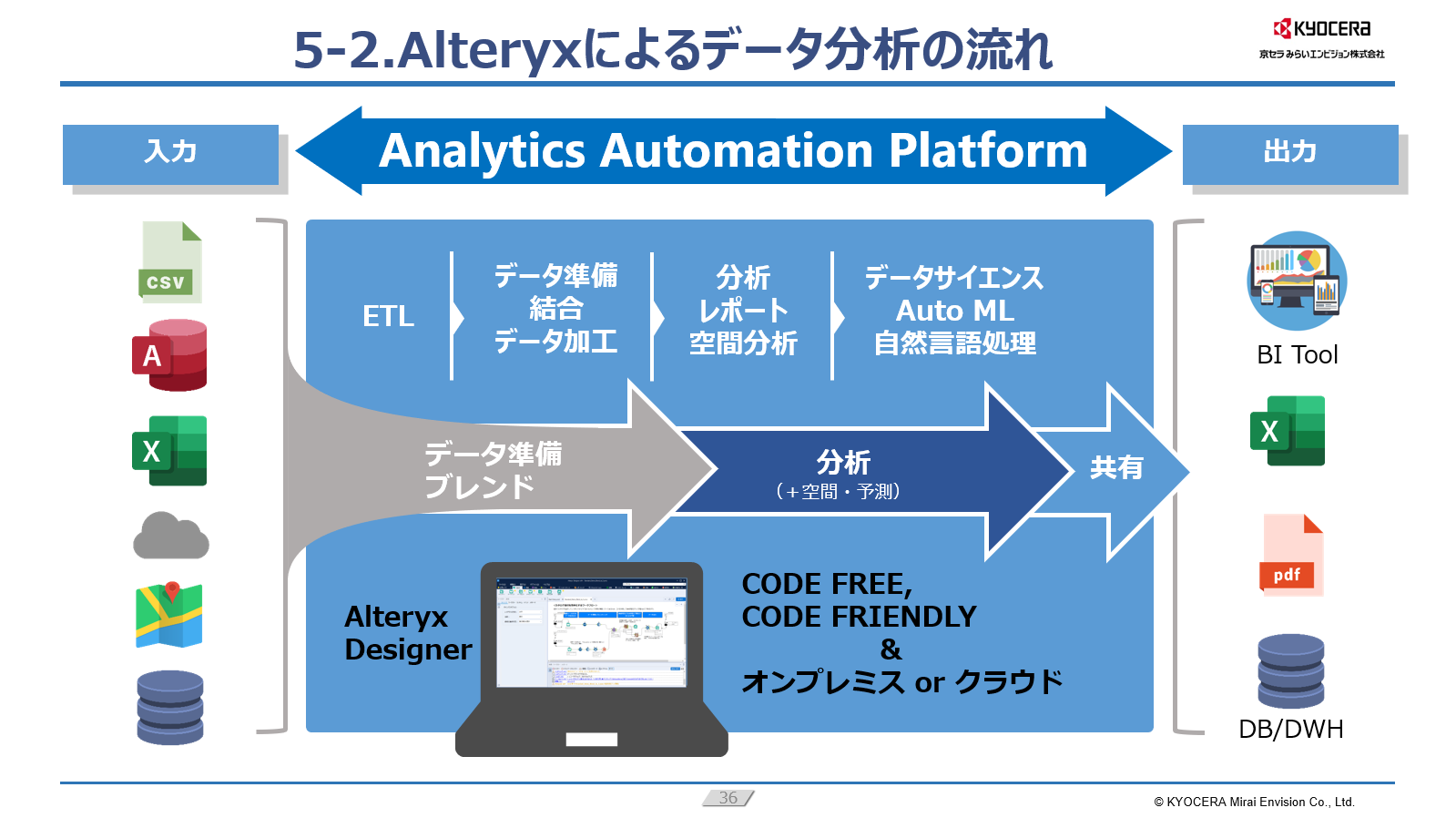

Alteryxはみなさんお持ちの様々なデータ、CSVファイルからデータベースまで接続を行います。そして、データ準備などを行い、さらに空間分析や機械学習モデルを使ったような予測分析などまで使うことも可能です。最終的には、BIツールやレポートなどの形で得られたインサイトを共有していく、というのが一連の流れです。これはCODE FREEと記載の通りプログラミングを行う必要はなく、300近い種類のツールを組み合わせて分析の内容を構築していきます

データ準備・データ分析を行っていくAlteryxですが、GUI操作を中心にしたインターフェースとなっており、プログラミングなしにデータ処理ができるためデータ分析の専門家がいなくてもデータ分析の推進を行うことが出来ます。

Alteryxで解決するデータ活用課題

前述したデータ活用の課題をAlteryxで解決する方法をご紹介します。

①データが膨大過ぎて、処理ができない

Alteryxは、GUIベースの直感的な操作で、複雑なプログラミングなしに「大量データを高速処理」するワークフローを構築可能です。「インメモリ処理」や分散処理を活用し、クラウド連携も容易なため、オンプレミス環境の制約を超えたスケーラブルなデータ処理を実現します。

②データが複雑すぎて、処理ができない

CSV、Excel、データベース、クラウドAPIなど、多様なデータソースや形式のデータを、直感的なドラッグ&ドロップ操作で容易にブレンド・変換・結合できます。視覚的なワークフローとして処理内容が可視化されるため、データ処理がブラックボックス化せず、複雑さを解消し、属人化も防ぎます。

③データを分析する人員の不足

Alteryxは、専門的なプログラミング知識がなくても、直感的なGUI操作で高度なデータ分析ワークフローを構築できます。これにより、ビジネス部門の担当者でもデータ活用を推進できるようになり、データ分析の属人化を防ぎ、複数人での作業共有や引き継ぎも容易になります。 一度構築したワークフローはボタン一つで繰り返し実行可能。これまで手作業で行っていたルーティン分析を自動化することで、人的ミスを削減し、人材をより戦略的な業務に集中させることが可能になります。

また、データの調査に関しては、多様なデータソース(CSV、Excel、各種データベース、クラウドサービスなど)に簡単に接続し、データのプロファイル(データタイプ、欠損値、ユニーク値、データ分布など)をGUI上で視覚的に確認できる機能を提供します。これにより、データタイプや品質に関する初期調査を迅速かつ正確に行うことが可能です。例えば、100210のような値が日付なのか金額なのか、迷うことなく判別できます。

データの準備は、データの損失(Null)の補完・削除、文字列内の空白除去、全角半角の統一、複数のデータ形式の標準化といった、データクレンジング(データラングリング)作業を、直感的な操作で自動化できます。これらの作業を視覚的なワークフローとして構築できるため、手作業によるミスを排除し、処理の透明性と再現性を高めます。

京セラみらいエンビジョンは導入時のサポートをはじめ、みなさまがAlteryxを使いこなせるように様々なサポートメニューを準備しておりますので、ご興味がございましたらお気軽にお声がけいただければと存じます。

おわりに

まずは手元にお持ちの各種のデータやファイルを徹底的に調査して必要なデータを抽出、定義を行うことが大切です。その後各アクションをとってデータラングリングを行い、データ分析の効率を考慮したら、何度も繰り返す操作を自動化するのが勝負のポイントとなります。また、進化し続ける機械学習の力を借りて、予測分析をより簡単に行うことが、データドリブンな意思決定の助けとなるでしょう。

Alteryxは、単なるデータ分析ツールではありません。データ収集から準備、分析、レポート作成に至るまでの一連のプロセスを「動的に自動化」することで、データ活用を次のステージへと導きます。多くの企業で、Alteryx導入により月次のレポート作成時間を大幅に短縮し、これまで属人化していた分析作業を標準化・自動化することで、人的リソースをより戦略的な業務に集中させ、生産性向上とコスト削減を実現しています。

無料トライアル相談も承っていますので、お気軽にお問い合わせください。